どんな話題?

最新の研究で、なんとディープフェイク動画の巧妙な偽装を見破るカギは、人の心拍にあることが判明! まるで名探偵が微かな証拠を見つけるように、AIではまだ完璧に再現できない、血液の微妙な流れを解析するんです。しかし、これはあくまで初期段階。今後のAIの進化で、この”心拍偽装”もクリアされるのは時間の問題でしょう。

先日、テレビで見たんですが、AI研究者たちが「AIにできないことは何か?」を考えるのが、まるで”鬼ごっこ”みたいになっているとか。新たな発見があると、すぐにAIが学習し、それを克服していく。今回の”心拍検出”も、いつまで有効なのか、ちょっと心配になっちゃいますね…。

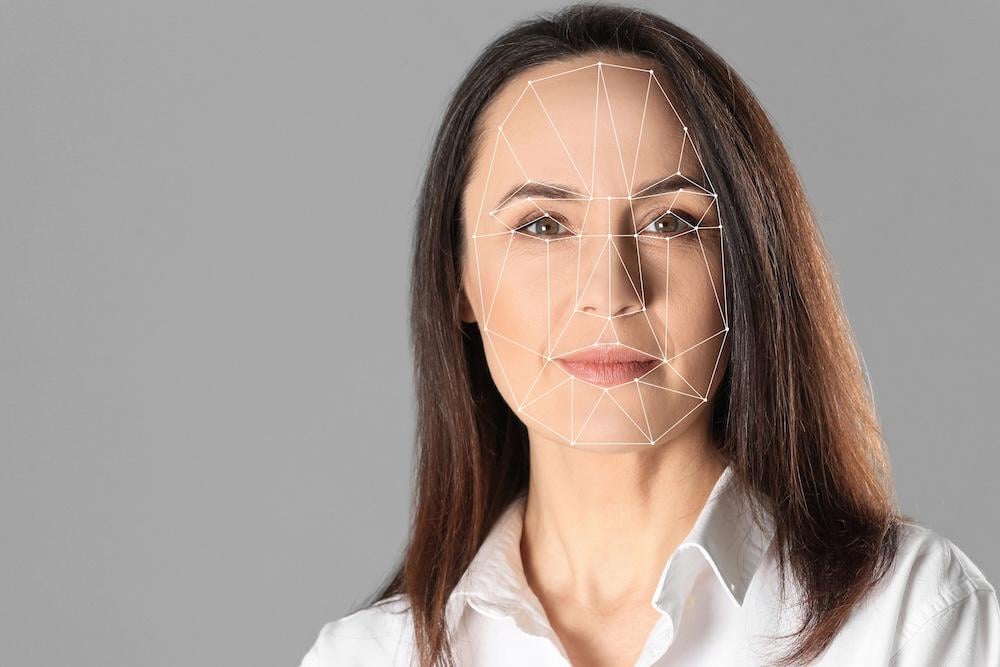

オランダ法科学研究所は、AIでは再現困難な心臓の鼓動による顔色の微細な変化を分析し、ディープフェイク動画を検出できる。

オランダ法科学研究所は、AIでは再現困難な心臓の鼓動による顔色の微細な変化を分析し、ディープフェイク動画を検出できる。

みんなの反応

深刻な分析でAIを見抜けないってのは違うんじゃね?一般人が見分けつかないのが問題なんだよ。ヤバいディープフェイクがSNSで拡散された後じゃ、ファクトチェックなんて見ないし、見ても信じねーっての。マジで終わってる。

次は何すればいいか、もうバレちゃったじゃん…。

キーワードは「まだ」だな。これからに期待しろってか。

元の技術はオイラービデオ拡大だってよ。CVアルゴリズムに興味あるやつは調べてみ。

未だにフォトショはピクセルのズレとか、全体的なピクセルの整合性で検知できるのに、AI生成画像にはそういうツールがないのが不思議なんだよな。AIが正しい静止画やアーティファクトまで再現できるようになったのか?

まず、この手法が広範囲で使えるほど正確なのか?AIのせいで誰かの人生を台無しにするのは避けたい。

これを打ち破って、AIが10倍速く学習するためのツールを与えるのにいくらかかったんだろうか…?意味あんの?

インターネット上で十分な品質の映像を見つけるのは難しいだろうな。高fps、高解像度が必要になるだろうし。

4月に出た研究論文によると、新しいビデオモデルには心拍があるらしいぞ…。

そんなこと誰にも言うなよ。今、何をすべきか分かっちまうだろ。

ディープフェイクを検出するネアンデルタール法医学研究所があるのかと思ったけど、ディスレクシアだったわ。

これが常に有効だとは思えんな…

この技術が民間セクターで利用できるようになるのか気になる。

仕上げに、進化はオランダ人を作った。

機械が見抜けるなら、機械はそれを学習できる。

なら、AIは次の「兆候」を学習して組み込むだけだろ…

スタジオレベルの完璧な照明の動画ならいいかもな。飲み会帰りの暗くて手ブレしてるスマホ映像じゃ無理だろ。

また明日

変な質問で悪いけど、肌の色が濃い人にも有効なの?

よし!オランダ人よくやった!

ソースは?

現在利用可能な、または将来開発される全てのアルゴリズムは、AIの学習に使われてアルゴリズムは役に立たなくなるんだよな。 🙁

研究すればするほど、論文を発表すればするほど、AIはその論文で学習する。猫とネズミのゲームだけど、AIの方が人間の研究より速く成長する。

ニュースキャスターとかセレブの厚化粧はどうなるんだ?微細な変化なんて分からないんじゃない?知らんけど。

ディープフェイク軍拡競争が始まったか…

コメント